[디지털투데이 유다정 기자] 유튜브에서 플레이되는 영상의 하단을 보면 자막(c) 버튼이 있다. 설정하면 오디오에 따라 자동생성되는 자막을 볼 수 있다. 자막이 나타나는 속도는 발화 속도와 비슷하지만, 다소 정확도가 떨어질 때도 있다. 이 기능의 기반은 머신러닝 음성텍스트변환 기술이다. 구글은 이 기술을 기반으로 난청 및 청각장애인도 실시간으로 소통할 수 있게 돕고 있다. 구글은 데이터를 수집해 그 정확도를 높이는 중이다.

구글코리아는 14일 오전, 역삼동 소재 구글코리아에서 AI 포럼을 열었다. 사가 사블라(Sagar Savla) 구글 AI 리서치 프로덕트 매니저가 화상 연결을 통해 구글의 머신러닝 기반 음성 텍스트 변환 기술 및 이를 기반으로 한 ‘라이브 트랜스크라이브(Live Transcribe)’를 소개했다.

지난 2월 구글은 대화를 실시간으로 자막으로 변환해 보여주는 '라이브 트랜스크라이브'를 베타버전으로 출시했다. 구글측에 따르면 실제 발화 시간과 시차는 200ms(밀리초) 미만이며, 현재 전 세계 인구의 80% 이상이 사용하는 70개 이상의 언어를 지원한다.

롤리팝(버전 5) 이상의 안드로이드 운영체제(OS)를 사용하는 누구나 150개국가 플레이스토어에서 무료로 다운로드받을 수 있다. 다만 엔진이 클라우드 기반이기 때문에 인터넷이 연결돼야 하며, 네트워크 환경이 좋지 않은 경우에 약간의 지연은 있을 수 있다.

현재 세계보건기구(WHO)에서는 전 세계 4억 6,600만명에 달하는 사람들이 청각 장애가 있다고 추정한다. 미국의 CART, 영국의 Palantypist와 같이 선진국에선 전사(轉寫) 서비스를 이용할 수 있다. 비용은 1시간에 120불 이상 정도로 비싸고, 미리 예약도 잡아야 한다. 즉흥적인 대화나 사적인 대화에선 사용하기가 어렵다. 구글이 인간 개입이 필요 없이 빠른 속도로 전사할 수 있는 서비스를 만든 이유다.

"I got a new jersey in New York."

구글 클라우드에 있는 엔진에선 이 문장이 디바이스를 통해 들려오면, 소리의 가장 작은 단위인 음소로 분리한다. 그 후 비슷한 위치의 두개 음소를 결합하면 'new'가 나온다. 사전에 있는 단어인지를 확인 후, [nuː]라는 발음이라는 언어모형(language model)을 생성한다. 대화에선 맥락의 이해도 중요하다. 위와 같은 문장에서 New Jersey(뉴저지)라는 지역이 아닌 셔츠의 일종인 jersey를 샀다는 것을 인식해 20ms 이내의 시간 안에 보여준다.

음성인식기술에서 가장 중요한 점은 소음과 음성을 구분하는, 이른바 '칵테일파티 효과'를 내는 것이다. 칵테일파티처럼 여러 사람의 목소리와 잡음이 많은 상황에서도 인간은 본인이 흥미를 갖는 이야기는 선택적으로 들을 수 있다는 점에서 명명된 이름이다.

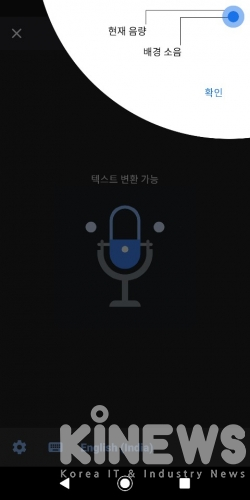

'라이브 트랜스크라이브'에서는 배경의 소음에 비해 사용자 음성의 음량이 어느 정도인지 시각화하여 보여주는 신호를 만들었다. 이 신호는 마이크가 화자의 음성을 얼마나 잘 인식하고 있는지를 즉각적으로 보여주기 때문에, 사용자가 신호를 확인하며 휴대폰의 위치를 조정할 수 있다. 아울러 이용자가 목소리 크기를 어느 정도로 내야할 지 알 수 있는 적절한 지표가 되기도 한다. 방 안은 조용한데 이를 파악하지 못하는 청각장애인가 목소리를 크게 내는 상황을 방지할 수 있는 셈이다.

아직까지 발화자가 많을 경우 이를 구분하는 것은 보완이 필요하다. 구글은 휴대폰 카메라를 통해 발화 중인 인물을 인식, 자막을 제공하는 방식을 고안하고 있다. 아울러 자사 클라우드 서버에 있는 엔진 또한 디바이스 내 적용해 인터넷 연결 없이도 이용할 수 있도록 개발 중이다.

현재 구글은 자동음성인식 기술을 유튜브의 자동 자막, 구글 프레젠테이션(Google slides), 전화 통화 등에 적용하고 있다.

사가 사블라 구글 AI 리서치 프로덕트 매니저는 "구글의 자동자막기능(transcribe)은 전세계에서 이용 중이고, 한국도 많은 이들이 이용 중"이라며 "한국어 오류율 또한 20% 미만으로 다른 언어들과 비교해봐도 좋은 수치다. (현재 완벽하진 않지만) 데이터가 많이 쌓이고 계속 분석하면서 정확도를 높이기 위해 노력하고 있다"고 전했다.

한편 구글은 청각 보조 기능 앰플리파이어(Sound Amplifier)도 출시한 바 있다. 안드로이드 스마트폰에서 유선 헤드폰을 연결하여 사운드 앰플리파이어를 사용할 수 있으며, 이를 활용해 주변의 소리를 필터링하거나 증폭시킬 수 있다. 구글플레이에서 다운로드할 수 있으며 안드로이드 파이(버전 9) 이상의 스마트폰에서 지원된다. 픽셀 3에는 '라이브 트랜스크라이브'와 함께 사전 설치됐다.

SNS 기사보내기

관련기사

- 타다, 장애인 및 65세 이상 교통약자 위한 ‘타다 어시스트’ 나온다

- SK텔레콤, 청각장애 택시기사 지원 나섰다

- 자동화 시대, 노인 일자리가 위협받는다

- LG유플러스, 장애인 생활편의 돕는 AI서비스 출시

- 구글플레이-중소벤처부, 해외 진출 지원 ‘창구' 프로그램 출범

- "용케도 알아 듣고 찰떡같이 받아 쓰네”...일상 스며드는 음성 인식

- 구글 "디지털 미디어 리터러시 교육 프로그램, 전국적으로 확대"

- 구글, 보급형폰 '픽셀 3a · 3aXL' 내달 7일 공개...스냅드래곤 710 탑재?

- 책 읽어 주고 나이 인식도 OK...내 폰 안의 '설리번 선생님'

- 한국 앱·게임 개발사, 글로벌 진출 장벽은 '노하우 부족'